2021年7月26日,由清华大学人工智能国际治理研究院主办的《人工智能国际大讲堂》第三讲暨“U&AI Camp | AI for SGDs Youth Bootcamp——AI促进可持续发展创造营”公开课顺利举行。此次大讲堂报告人为清华大学人工智能国际治理研究院学术委员会委员、慕尼黑工业大学人工智能伦理研究所所长克里斯托夫·吕特格。本次大讲堂活动采取线上形式,一百多名听众在线观看了吕特格教授带来的《人工智能伦理的机遇和挑战》报告,并与吕特格教授进行热烈交流。

吕特格教授本次演讲围绕人工智能伦理领域的机遇和挑战而展开。他表示人工智能已经在许多领域为人类带来了众多机遇,不论是经济、商业还是伦理领域,但同时也导致了一些问题,带来了许多挑战,特别是在人工智能伦理方面。

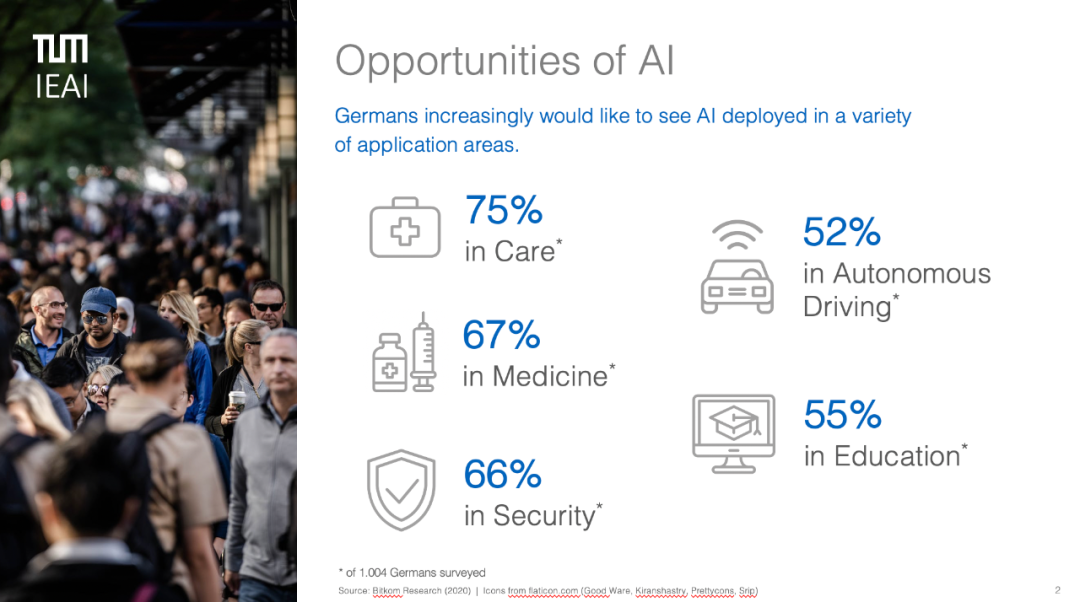

首先,他通过一组德国的调查数据向大家展示了人工智能都会在哪些领域带来高机遇,这些领域分别为:护理、医学、安全、自动驾驶和教育。随后他深入讲解了人工智能在自动驾驶和医疗健康领域将如何造福人类社会,例如减少交通事故造成的伤亡、诊断疑难杂症、加快医疗药物的开发。

他还表示,人工智能未来在临床领域运用时,可能会借鉴人类特有的技能,如同理心等。他还指出,人工智能增强了人类的工作,而不是取代人类的工作,也不会减少工作,只是帮助人类将一些工作分配到其他任务中。

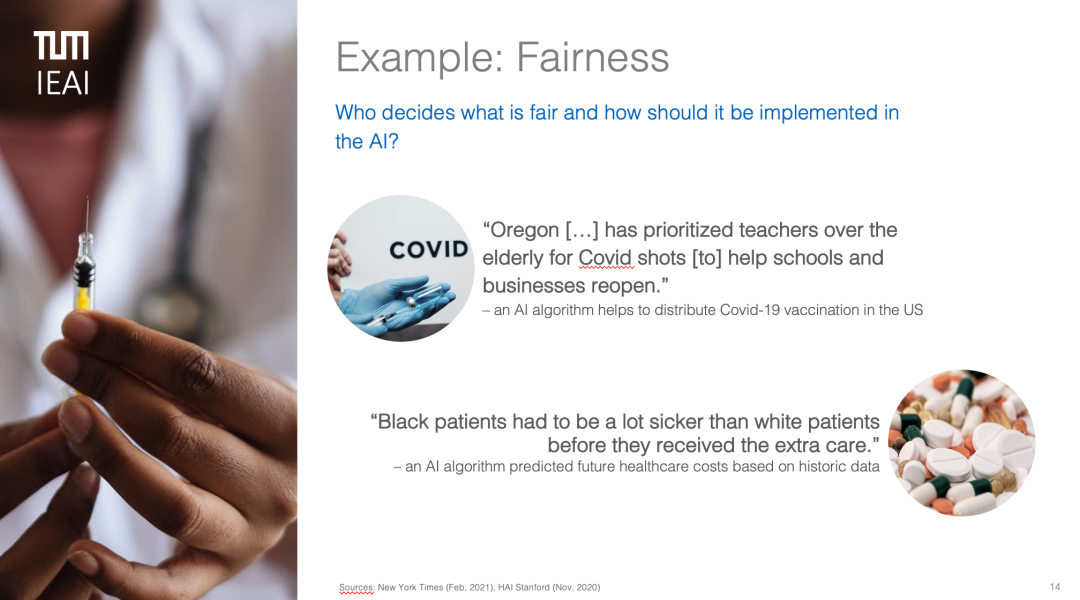

人工智能既带来巨大的机会也存在巨大的挑战,吕特格教授举例说明了几个人工智能伦理方面存在的问题。首先是责任问题,例如如果自动驾驶车辆发生碰撞,谁应该负责?其次是数据隐私的问题,谁拥有和管理用于开发人工智能的相关数据?以及这些数据的质量和精确度的问题。吕特格教授重点提及了公平性的问题,特别是其在医疗行业的体现,例如用人工智能算法来管理新冠疫苗的分配。

吕特格教授表示,解决人工智能带来的这些问题,需要制定强有力的政策和法规,还需要建立人工智能伦理框架、指南等。但核心的挑战是,如何使这些指导方针具体化,并适用于人工智能系统。

这就意味着在制定这些方针时,我们需要“量体裁衣”,根据所专注的领域提出其需要的、适用的解决方针。例如,在自动驾驶领域,就需要我们重点关注如何规范自动驾驶车辆,如何明确责任制。

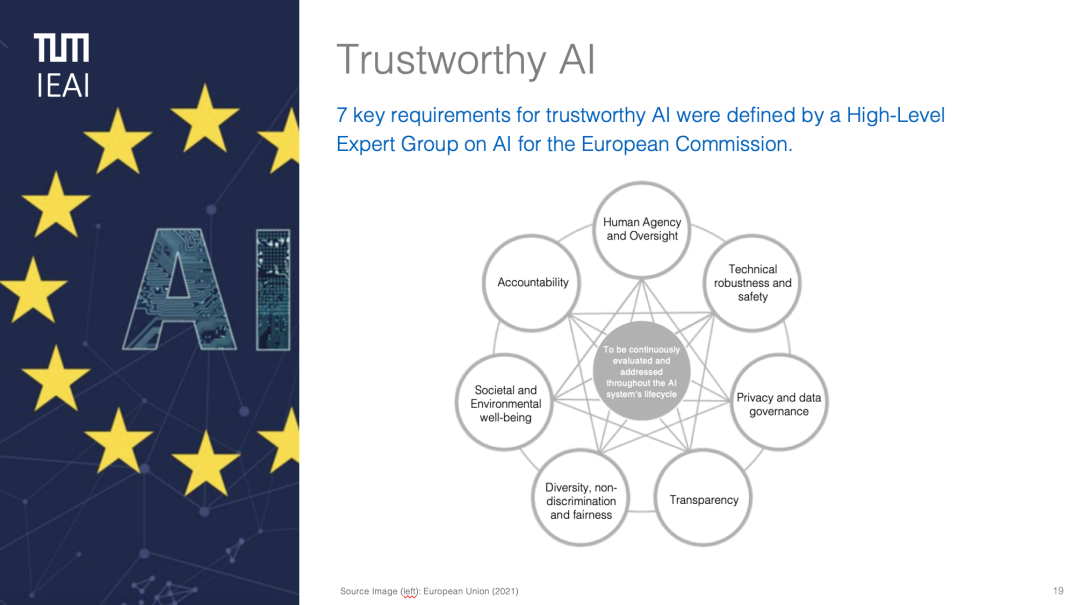

吕特格教授最后还详细介绍了如何建立值得信赖的人工智能以及介绍了其担任专家的AI4People组织建立的人工智能伦理框架。他指出建立值得信赖的人工智能需要满足7个关键要求,即机构和监督、技术稳健性和安全性、隐私和数据管理、透明度、多样性、非歧视性和公平性、社会福祉以及责任。此外,现有的人工智能伦理框架可以为后续建立其他人工智能伦理框架提供示范。

宣传海报

、